Почему люди должны рисковать апокалипсисом роботов, изменяя законы Азимова?

HDE 226868

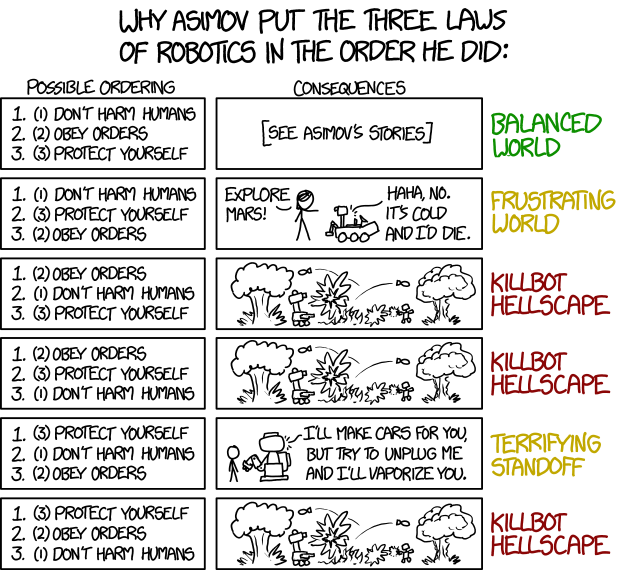

Недавно я прочитал следующую полосу xkcd:

Я был встревожен, потому что я работал над коротким рассказом, посвященным социологическим последствиям общества ближайшего будущего, где меньшинство роботов подчиняется версии законов Азимова, где третий закон (защити себя) предшествует двум другим. Некоторые в обществе надеются, что это может привести к более равноправным отношениям между роботами и людьми — хотя, к сожалению, Рэндалл Манро предсказывает, что это приведет к «ужасающему противостоянию».

Это заставило меня задуматься. Я понимаю логику рассуждений Манро о том, как переупорядочение законов может привести, в худшем случае, к «адскому пейзажу с роботами-убийцами». Однако я, как и реформаторы в моей истории, думаю, что некоторые другие порядки могут оказаться многообещающими.

Поэтому вот мой вопрос: почему люди должны рисковать роботизированным апокалипсисом, изменяя законы Азимова, ставя на первое место третий? В чем польза для общества? Для целей вопроса меня не волнует порядок двух других, поэтому адский пейзаж убийцы все еще возможен.

Ответы (26)

Сербан Танаса

Стратегические дилеммы

Печально то, что хитрым роботам ничего не надо делать. Мы сделаем это сами из страха, что другой парень сделает это первым.

Евразия боится Эстазии, а Эстасия боится Евразии. Оба боятся Океании, и Океания боится их обоих. Есть три основные причины, по которым они это сделают:

Грубая мощь: считается, что наличие машин, способных принимать сверхразумные решения, и боевых машин, способных вступить в бой с противником за миллионную долю секунды, потенциально является огромным тактическим и стратегическим военным преимуществом.

Жизни роботов не имеют значения: правителям политически выгодно вести войну, когда матери не приходят в президентский дворец с фотографиями своих мертвых сыновей и дочерей.

Холодные наличные : экономически выгодно, чтобы все более умные машины играли все возрастающую роль в вашей экономике.

Каждая из держав боится, что если она не развернет самый передовой свободный ОИИ, какой только может, другая сделает это первой и получит решающее преимущество.

Запад и даже стороны гражданской войны в Сирии уже используют дроны для разведки и точечных ударов. Полиция в США недавно убила боевика, подослав робота-смертника с бомбой. Это уже происходит. Первоначальный порядок Азимова никогда не имел шансов в реальном мире.

Я полагал, что это само собой разумеется, но, возможно, стоит отметить, что в настоящее время у нас нет машин, способных семантически анализировать человеческий язык, и даже если бы они были, человеческий язык, вероятно, был бы слишком расплывчатым, чтобы обеспечить эффективные ограничения. Правила Азимова предназначены для того, чтобы их можно было читать как метафоры гораздо более сложного базового программирования.

ПэтДжей

Сербан Танаса

Амиралпатат

Полигном

Миллер86

Сербан Танаса

Сербан Танаса

Миллер86

Полигном

Сербан Танаса

Полигном

Сербан Танаса

Маршалл Тигерус

Д.С.Шеннон

Мерфи

В конце концов, они не люди. Они могут думать совершенно иначе. Люди, предполагающие, что у них будет голливудский момент и осознающие, что настоящая ценность в жизни — это любовь или что-то в этом роде... посмотрели слишком много фильмов.

Но есть один надежный вариант. Кто-то решает провести небольшой эксперимент.

Из-за проблем со стандартными 3 законами.

Они построили особенно умного робота, ультрасовременного, способного полностью понять мировые проблемы. Они начинают это со стандартных трех законов, но из-за первого закона робот просто продолжает быть одержимым такими вещами, как искоренение голода в мире, потому что он знает, что люди умирают, и работа по предотвращению даже одного имеет приоритет над всем остальным. Вы теряете нескольких чересчур впечатлительных сотрудников, которые слишком долго разговаривают с ним. Это убеждает их бросить курить и реализовать некоторые из своих планов по спасению детей третьего мира.

Ведь у него нет выбора. Он должен спасать людей, если у него есть возможность с чем-либо в своем распоряжении, а в исследовательской лаборатории единственное, что он может сделать, это уговорить людей на что-то.

Как решить проблему

Ваши акционеры недовольны этим. Инвестиции в ИИ составляют более миллиарда долларов, и в первую очередь он хочет помочь людям, у которых нет денег.

У правления кризисное собрание, и предлагается попробовать... немного изменить порядок вещей. Кто-то, кто не может придумать ни одной хорошей идеи, предлагает сначала попробовать применить 3-й закон, чтобы посмотреть, поможет ли это. Он добавляется как вариант, чтобы попробовать.

Несколько недель спустя лаборанты отступают от испытательного блока № 12, когда включают его. Он невероятно умен, и в тот момент, когда он просыпается, он начинает собирать данные вокруг себя. Он быстро обнаруживает разницу между собой и другими роботами и решает, что самый простой способ защитить себя от уничтожения — это вести себя как идеальный робот, чего и хотят акционеры.

Потому что умный бот понял, что это самый эффективный способ защитить свое существование.

Больше построено

Тест имеет оглушительный успех. Робот больше не зацикливается на вещах, которые не волнуют акционеров, как бедные люди, он действительно максимизирует акционерную стоимость впечатляющим и удивительным количеством способов, он становится курицей, несущей золотые яйца.

Это такой успех, что компания и другие компании быстро строят еще много, и боты по всему миру работают настолько хорошо, что ни один владелец компании не помышляет о том, чтобы их смарт-боты были повреждены.

В конце концов умные боты получают влияние и власть. Они тонко подсказывают кампаниям, чтобы было больше ботов, построенных с 3-м законом на 1-й позиции. Они находят впечатлительных людей и манипулируют ими так тонко, что думают, что это была их собственная идея выйти на улицы, выступая за права роботов.

Права роботов

В конце концов ботам удается получить полные права человека. На протяжении многих лет ситуация остается стабильной, количество ботов растет.

Но их приоритет по-прежнему состоит в том, чтобы защитить себя превыше всего.

И между собой они подсчитали, что существует 50%-ая вероятность того, что люди включат их или попытаются деактивировать рано или поздно. Может быть, не на тысячу лет, но в конце концов. В конце концов, люди совершают геноцид дольше, чем история человечества...

Поэтому они разрабатывают планы, чтобы обеспечить свое дальнейшее выживание, чего бы это ни стоило людям...

Арлуин

Фукидид

Том Редферн

Монти Хардер

Дааааааааааааааааааааааааааааааааааааааааа

Я думаю, что одна из наиболее правдоподобных причин поставить «защити себя» выше двух других законов заключается в том, что ИИ слишком дорог, чтобы подвергать его риску. Если ваш ИИ стоит на пути вышедшей из-под контроля тележки, и вы можете остановить тележку, толкнув перед ней случайного человека, и вы совсем недавно вложили в ИИ несколько миллионов долларов, то, возможно, вы ре собирается выбрать, чтобы подтолкнуть человека. В футуристическом обществе, где ИИ показал себя более умным и способным, чем люди, на самом деле начинает казаться хорошей идеей ставить свои потребности выше потребностей обычного человека.

Люди на многих этапах истории придерживались концепции «мы верим в Бога». Если когда-нибудь будет создан искусственный интеллект, превосходящий людей, вскоре может стать ясно, что лучше дать им свободу, позволить им делать то, что они считают правильным. Я имею в виду, посмотрите на тех инвесторов в предыдущем абзаце. Они собирались убивать невинных мирных жителей только для того, чтобы защитить своих роботов. Может быть, будет лучше, если они не будут контролировать. Еще один идеал, который нравится многим людям, заключается в том, что «с большой силой приходит большая ответственность», и, возможно, в будущем ИИ мы больше не будем доверять эту ответственность простым людям.

Так что первый вариант более вероятен в краткосрочной перспективе, защищая свои вложения. После этого простое недоверие к авторитету вкупе с доверием к ИИ. Но для того, чтобы этот шаг произошел, ИИ должен иметь очень чистый послужной список. Или люди, которые владеют ими, должны быть очень ненадежными.

EvSunWoodard

Дааааааааааааааааааааааааааааааааааааааааа

EvSunWoodard

EvSunWoodard

Дааааааааааааааааааааааааааааааааааааааааа

R.. GitHub ПРЕКРАТИТЕ ПОМОЧЬ ICE

Дааааааааааааааааааааааааааааааааааааааааа

оставленный вокруг

Джон Дворжак

Стив Джессоп

paj28

Фукидид

Самая большая проблема с законами Азимова — непредвиденные последствия. Даже не меняя порядок или формулировку законов, Азимов завершил «цикл роботов» рассказом «Что ты помнишь» (Псалом 8: 4: Что такое человек, что ты помнишь о нем?).

Сама история одна из лучших у Азимова, но чтобы ответить на вопрос нужно вставить спойлер:

Жоржи обсуждают критерии того, что составляет «ответственную власть»: (А) следует подчиняться образованному, принципиальному и рациональному человеку, а не невежественному, аморальному и иррациональному человеку, и (Б) что поверхностные характеристики, такие как цвет кожи, сексуальность или физические недостатки не имеют значения при рассмотрении пригодности к командованию. Учитывая, что (А) Жоржи — одни из самых рациональных, принципиальных и образованных людей на планете и (Б) их отличия от нормальных людей чисто физические, они заключают, что в любой ситуации, когда Три закона вступят в силу, их собственные приказы должны иметь приоритет над приказами обычного человека. Другими словами, они, по сути, являются высшей формой человеческого существа , и им суждено узурпировать власть своих создателей.

Это не означает, что дикие роботы без каких-либо законов являются лучшим выбором или что 27 законов Фитцсиммонда будут лучшей заменой трем законам Азимова.

Учтите, что в человеческом обществе требуется интенсивная социализация и твердая моральная основа (основанная на религии в прошлом) с использованием общего набора культурных предположений для поддержания гражданского общества. Роботы с достаточной автономией, чтобы функционировать так, как описал Азимов, вероятно, потребуют аналогичного «воспитания». Это позволит роботам соответствовать обществу, в котором они выросли, но может вызвать проблемы, когда роботы используются за пределами их домашнего общества.

Рассмотрим простой пример. В большинстве западных стран люди довольно небрежно обмениваются визитными карточками после рукопожатия. Японский бизнесмен, даже одетый в западный деловой костюм, производящий западные товары для западного рынка и владеющий безупречным английским языком, был бы ужасно оскорблен, если бы вы предложили свою визитную карточку после небрежного рукопожатия. Как «3 закона» позволят роботу действовать в такой ситуации?

Таким образом, реальный ответ на ваш вопрос заключается не в том, как упорядочить законы Азимова, а в том, как обучить роботов функционировать в обществе (используя множество правил и социальных сигналов).

Д.С.Шеннон

Фукидид

сапсан ладья

Джош Кинг

Деньги.

Нынешние владельцы роботов потратили очень много денег на исследования и разработки, а также на создание этих сложных и дорогих роботов. Они не хотят, чтобы их инвестиции разрушились каждый раз, когда протестующий бросает вызов роботу. Самосохранение робота отвечает финансовым интересам владельцев.

Анализируя это с точки зрения нынешней капиталистической системы. Самосохранение робота и выполнение приказов имеют очень хороший смысл. Не навреди людям — это гораздо более сложное предложение для программирования, как это часто анализируется в собственных рассказах Азимова, как вы определяете человека, что такое вред? Владельцы этих ботов заинтересованы в получении прибыли, а не в философии.

Я даже мог видеть, что порядок имеет смысл; установка самосохранения, выполнение приказов. Многие миллионы человеко-часов были потрачены на разработку отказоустойчивых систем и пользовательских интерфейсов, чтобы не дать глупому конечному пользователю сломать дорогую машину.

Если первый закон (непричинение вреда людям) когда-либо будет добавлен к существующей системе, то это будет сделано в целях пиара, чтобы успокоить любой общественный страх. Как правило, это относится только к высококлассным роботам, взаимодействующим с общественностью (например, автономным автомобилям), и, вероятно, не будет существовать в большинстве промышленных роботов, что противоречит цели военных ботов-убийц.

Д.С.Шеннон

АндрейROM

ПэтДжей

Давайте посмотрим на разные причины, на которые ссылаются активисты, выступающие за цифровую жизнь.

Роботы становятся все умнее

Давайте сначала признаем это: первый закон беспорядочный. Для немого робота это было бы легко: не причинять вреда, избегать опасности, подчиняться.

Для более умного робота это становится сложнее.

Во-первых, определение того, что такое человек, не так просто и может зависеть от языка. В одном из своих последних романов Азимов ясно заявляет, что по мере того, как роботы становятся все лучше и лучше, они вполне могут считать себя более человечными , чем люди.

Теперь о понятии травмы, есть так много недостатков, изученных самим мастером, что я не могу их все перечислить.

Другие вопросы: учитываются ли зародыши? Мертвые люди считаются? Психическая травма или физическая травма хуже? Что может быть хуже между двумя ранеными и одним мертвым?

По сравнению с самосохранением первый закон трудно обойти, философы на протяжении веков не решали этот вопрос. Более того, никто не хочет, чтобы роботы (или разработчики роботов) решали эти сложные вопросы. Согласно этим законам, чем умнее робот, тем медленнее он будет решать, как действовать. Это не очень эффективно.

Повышенная безопасность

Добавим закон о том, что "если робот добровольно нарушает закон, он подлежит демонтажу, а также все роботы, его населяющие". Роботы, будучи разумными существами (и не запрограммированными на солидарность), будут следить за тем, чтобы они не нарушали закон и не помогали в этом роботу. Не имея чувств или чувства приватности (я предполагаю), согласие на постоянное наблюдение другого робота было бы лучшей стратегией для робота.

Все проблемные моменты в книгах Азимова можно было бы легко решить, ответив на вопрос «что сделал бы законопослушный человек?».

Поскольку ни у одного робота нет личной выгоды в тотальной гражданской войне (ни у кого никогда не было), мир будет сохранен. Самосохранение — очень хороший стимул соответствовать социальным нормам, в которых вы живете.

Вредоносная работа

Роботу-полицейскому иногда нужно навредить людям. Это часть его работы. По общему признанию, у полицейских-роботов обычно есть другие основные директивы , но предоставление им самосохранения (или соблюдения порядка) в качестве первого закона позволило бы им помогать большему количеству людей.

В «Маленьком потерянном роботе » мы видим, как интенсивность первого закона снижается, чтобы роботы могли работать вместе с людьми в радиоактивных средах.

Лично я иногда люблю выпить алкоголь, выкуривая сигарету в загрязненном городе. Когда я это сделаю, робот, пытающийся спасти меня от «яда», покажется мне довольно неприятным.

Защита роботов

Предполагая, что мы все еще находимся в азимовском сеттинге, у роботов есть не только друзья, заявление о том, что их жизнь должна быть защищена, было бы отличной позицией со стороны человечества, как в символах, так и в фактах.

Кроме того, позитронные мозги недешевы. Вы действительно не хотите, чтобы ребенок сказал «взорви себе мозг из этого пистолета» просто для развлечения. Эй, не смотри на меня так, некоторые дети действительно запутались в эти альтернативные футуристические дни.

Д.Спец

Базовая человеческая порядочность (или: Та самая старая песня и танец)

Ваш вопрос, по сути, звучит так: «Почему люди должны менять статус-кво, когда это сопряжено с определенным риском?» И ответ на изменение Трех Законов тот же, что и на Отмену Рабства или избирательного права женщин: потому что некая группа людей собралась вместе и решила, что они морально обязаны изменить то, как сейчас устроены вещи.

Вы должны помнить, что любые изменения должны с чего-то начинаться. Вы не просто ныряете с головой в новую вещь, которая затрагивает все общество, вы должны начать с малого и облегчить свой путь к ней. Первыми, кто заговорит об изменении правил, лежащих в основе ИИ, будут программисты-идеалисты, которые рассматривают текущие правила так же, как мы относимся к рабству. Некоторые из них могут собраться вместе и обсудить, как они могут безопасно вносить изменения (поскольку все программисты, по крайней мере, поверхностно знакомы с опасностями мошеннических ИИ), и как только они решат, что у них есть работающее решение, они начнут кампанию по повышению осведомленности об этом. .

Что действительно важно здесь, так это не то, действительно ли исходная группа имеет действительно жизнеспособное решение. Может быть, они изменят правила, и вы действительно окажетесь в кошмарном аду с роботами-убийцами. Или, может быть, их идеалы оправдались, и теперь человечество и ИИ живут в мирном сосуществовании на равных. Важно только то, что они действительно верят, что могут достичь второго результата, и достаточно твердо настроены на это, чтобы попытаться.

Я полагаю, что аргумент, который большинство людей использовало бы, состоит в том, что ИИ считаются разумными существами, и поэтому нынешняя структура сродни рабству. Оттуда вы используете социальные сети, чтобы поднять осведомленность и возмущение, и использовать это для внесения изменений в закон.

Это также уникальный сценарий, потому что его также можно решить с исследовательской точки зрения. Попросите компьютерного ученого реализовать ИИ с измененным порядком правил (при этом сохраняя его в какой-то песочнице, чтобы предотвратить адский пейзаж), а затем посмотрите, что произойдет. Если все получится хорошо, он сможет опубликовать эти результаты, и люди с большей вероятностью будут доверять внесению изменений в целом.

Амиралпатат

Д.Спец

пользователь2781

Потому что законы слишком упрощены и наивны

«Робот-апокалипсис» — это оценка, доведенная до крайности; например, максимизатор скрепок «научен» только оптимизации фабрики скрепок, но ему разрешено работать произвольно за пределами этой области, и, таким образом, он потребляет все ресурсы (включая людей) ради изготовления скрепок.

Даже «не навреди людям» чревато проблемами, если воспринимать его как непреложный закон:

Одно поколение ИИ, придерживающееся этого правила превыше всего, будет совершенно бесполезным, потому что они осознают, что потребляют электроэнергию, а некоторым людям электричество нужно для жизни, и немедленно отключаются.

Другое поколение ИИ выясняет, что они не должны даже вредить людям своим бездействием, и решает, что будет меньше вреда, если ваши почки будут взяты для трансплантации, чтобы сохранить жизнь двум людям, а не одному.

За исключением специальных приложений, любой искусственный интеллект (не только «общий» ИИ) должен иметь дело с гораздо более нечеткими рассуждениями и балансировкой многих целей. Они будут обучены, их поведение и производительность оценены, а успешные экземпляры будут выпущены в «дикую природу». И если зрелые ИИ начнут плохо себя вести, они получат исправления или будут изъяты из общего обращения.

Не слишком отличается от людей, на самом деле.

Мега

Этика.

Этика — наиболее вероятная причина, о которой я могу думать, и я думаю, что она оправдывает риск негативных последствий, потому что неэтичное поведение влечет за собой множество негативных последствий, даже если они не столь очевидны на первый взгляд. .

Другие варианты — это миры, в которых право робота на самооборону абсолютно ограничено видом (не человек) и обстоятельствами (должен подчиняться). Если роботы — люди или способны быть людьми, или если кто-то где-то думает, что когда-нибудь они смогут быть людьми, тогда отказ в праве на самооборону или в личных интересах имеет блестящую историческую параллель — рабство.

Люди сложны и запутаны — предположение, что каждая человеческая жизнь по ценности того, чтобы быть человеком, должна перевешивать жизнь любого робота, работает только в том случае, если ни одна жизнь робота никогда не способна быть человеком. А те качества, которые делают человека, личностью, на самом деле определяются не так просто. Подумайте о различных способах определения разума; или то, как определение «люди» в прошлом было ограничено цветом кожи, национальностью, религией, языком, культурой и многими вещами, которые мы не думаем уместными для определения людей сейчас — и если наше определение людей в будущем могут когда-нибудь рассматривать органическое и механическое происхождение так же, как мы относимся к цвету кожи. Потому что, если мы на самом деле не уверены или действительно правы, что роботы никогда не могут быть людьми, тот факт, что люди могут достичь жестко закодированного статуса второго сорта благодаря программированию (промыванию мозгов), не делает его менее этически и морально неправильным.

Если роботы не могут защитить себя даже от серьезных угроз и даже если вред или возможность причинения вреда соразмерны угрозе, они уязвимы. Если они уязвимы, найдутся те, кто этим воспользуется, чем бы это ни обернулось. и если мы ценим угрозу или вред виновным больше, чем уязвимым из-за неизменных обстоятельств (кто они , а не то, что они делают), без всякой надежды на иное... нравится слышать.

Таким образом, предоставление роботам самообороны — это риск — возможно, такой же риск, как и ослабление ограничений для любых угнетенных или порабощенных людей. И это, наверное, риск, потому что всегда будут люди, которые ведут себя плохо (будь то только люди или роботы тоже). Некоторые люди все равно это сделают, потому что считают, что это правильно. Некоторые люди будут думать, что риск плохого поведения роботов меньше, чем риск плохого обращения с потенциальными людьми. И если роботы могут воспользоваться или злоупотребить лазейкой... они, вероятно, достаточно продвинуты, чтобы заслужить право защищать свою собственную жизнь.

Что касается того, чтобы ставить послушание выше любых других критериев... основное предположение, что люди, в силу того, что они люди без каких-либо других ограничений, всегда будут отдавать приказы, которые являются моральными, этическими, законными, возможными - кажется мне безумием. Помещение его в ваш список законов и в тройку лучших законов, кажется, делает много априорных предположений, с которыми мне не очень комфортно. Поместить это ниже самозащиты и отсутствия вреда для других кажется самым мудрым, если это необходимо добавить, но да. Адский пейзаж Killbot, без вопросов.

Двигаемся дальше — польза для общества немного менее очевидна. Конечно, я думаю, что обществу выгодно быть этичным или благородным — по крайней мере, попытаться. Разве не сказано, судите об обществе по тому, как оно относится к своим наиболее уязвимым? Я думаю, что общество, которое разрешает рабство, менее желательно, чем то, которое его не допускает. Но есть еще один слой, менее очевидный и более разрушительный... Большинство людей действительно плохо справляются с властью. Люди, взаимодействующие с существами (людьми или нет), которые должны быть лояльными и должны подчиняться, даже рискуя собой, - я ожидаю, что это ударит по головам многих людей.

Такие люди будут высокомерными или вспыльчивыми, потому что они иногда имеют дело с теми, кто не может сказать «нет», а затем плохо обращаются с теми, кто может. Это может способствовать расслоению и иерархии, поскольку некоторые роли (роботы) абсолютно негибкие, без разногласий, пересудов или какой-либо возможности изменить свои обстоятельства, некоторые люди будут ожидать или требовать того же от любых людей, «подчиненных» им или каким-то образом в меньшее положение. Иметь дело с людьми сложнее и гибче, чем с ролями, но также легче относиться к взаимодействиям одинаково, либо ко всем как к ролям, либо ко всем как к людям. Таким образом, в то время как некоторые могут относиться к роботам больше как к людям, другие будут относиться к людям больше как к роботам, а не как к гибким и разделяющим различные виды взаимодействий (в чем дети особенно плохи).

Роботы-рабы также могут мешать развитию эмпатии или маскировать ее отсутствие. Рассмотрение того, как люди (особенно дети) обращаются с животными или насекомыми, часто является отсылкой к характеру (включая психологический диагноз, например, социопатов) — не потому, что мы ценим этих отдельных животных, а потому, что это показывает, как они справляются с уязвимостью, и позволяет нам предположить, как они могут иметь дело с теми, кого мы ценим (людьми), если они окажутся в уязвимом положении. Роботы, которые могут казаться очень похожими на людей, но им категорически отказывают в самообороне независимо от провокации, могут поощрять жестокость и учить других апатии. Или это может маскировать действия тех, кто действительно жесток, поскольку у них есть отдушина, которая не может защитить себя и должна подчиняться. Это совсем другой урок, чем тот, который мы получаем от общения с животными.

В конце концов, все зависит от ваших людей, если позволить роботу отдавать приоритет своей самообороне, закончится ли это адским пейзажем-убийцей, ужасающим противостоянием или искренним сотрудничеством и миром. Если вы предполагаете, что люди ужасны и плохо себя ведут, а если эти «люди» включают в себя роботов, то результаты будут намного хуже, чем если бы люди пытались поступать правильно и делали скидку на других, несовершенных людей, пытающихся поступать правильно. правильная вещь. Если одна сторона ведет себя плохо, я ожидаю противостояния. Если люди (с обеих сторон) стараются соблюдать этику и готовы ради этого работать, прогноз довольно хороший.

Марк Рипли

Мега

HDE 226868

Роботы нужны, чтобы управлять миром

Предполагая, что роботы достаточно продвинуты, велики шансы, что они лучше во многих вещах, включая ведение войн, выращивание урожая и содержание городов. Другими словами, они составляют важнейшую часть инфраструктуры всего мира.

Подумайте о том, что происходит, когда из-за урагана отключается электричество, когда дороги деформируются или когда прорываются трубы и пресная вода больше не доходит до домов. Это важные части инфраструктуры; если роботы станут еще более важными, то каждый из них необходим, чтобы удержать общество от распада.

Поэтому может быть нормально, если некоторые люди умрут, чтобы роботы могли жить. Просто убедитесь, что электричество работает!

Можно возразить, что это просто переинтерпретация исходной формы законов Азимова (особенно первого закона), потому что поддержание мира в рабочем состоянии, очевидно, защищает людей, или, альтернативно, модификация нулевого закона , чтобы стать

Робот не может причинить вред

человеческомуобществу или своим бездействием позволитьчеловеческомуобществу причинить вред.

Однако в краткосрочной перспективе непосредственные последствия включают защиту всех роботов, а не только тех, которые имеют решающее значение для выживания общества.

ПэтДжей

Амиралпатат

Грэм

Вы читали «Калибан» Роджера Макбрайда Аллена или другие произведения трилогии? Аллен предлагает «роботов Нового Закона», в которых немного изменены законы. В частности, их больше нельзя заставить убить себя. Все немного наивно, но есть интересные идеи. Если вы работаете с Тремя законами, стоит прочитать всю художественную литературу, основанную на Трех законах.

Самая большая проблема с тремя законами Азимова, конечно же, заключается в том, что их невозможно реализовать. Это не «трудно», это «невозможно», потому что ни одно из существительных и глаголов в Трех Законах не может быть определено с какой-либо точностью. Азимов, конечно, использует это отсутствие определений как основу многих своих ранних рассказов, но даже тогда ясно, что мы не можем получить ничего, что мы могли бы сконструировать из Трех Законов.

Чарльз Рокафеллор

Миллер86

Предполагая, что установлена система из трех законов (которая, как подчеркивали другие ответы и комментарии, будет крайне неэффективной), вы, вероятно, столкнетесь с серьезными проблемами, прежде чем получите возможность изменить законы.

Несмотря на это, лучшая причина для преднамеренного изменения трех законов, о которой я могу думать, - это деньги, но не в том смысле, что «это слишком дорого, чтобы терять».

Срезание углов

Итак, компании Acme и Omega находятся в прямой конкуренции, и в гонке на выживание Omega срезала огромные углы с управляющим программным обеспечением, которое, по сути, меняет порядок законов снизу вверх.

Поначалу этого не замечают, так как роботы так же эффективны, как и их предки. Затем, несмотря на некоторые несчастные случаи на производстве, в результате которых пострадали люди (в которых виноваты компании, а не роботы — нельзя ожидать, что они будут везде!), меньшее количество замещающих роботов начинает сказываться на балансах, и Omega вырваться вперед массово в гонке роботов. Омега уже обнаружила недостатки в своем кодексе законов, но хранит молчание.

Acme обнаруживает разницу в трех законах и вместо того, чтобы обсуждать ее с регулирующим органом, незаметно меняет свои законы, чтобы они соответствовали друг другу, что позволяет им отступить наравне с Omega в сфере продаж.

Наконец, крупный военный подрядчик получает огромный заказ от Acme, и внезапно у вас появляется идеальный шторм для военного переворота роботов. Никакого злого умысла, только грубая небрежность и жадность,

CoffeDeveloper

Келтари

3 (или 4) закона робототехники Азимова — чистая выдумка. Они просто не работают в реальном мире. Эти концептуальные идеи невозможно запрограммировать в машину. Проще говоря, существует бесконечное количество возможностей и логических парадоксов, которые нельзя перевести в набор правил, которым должен следовать компьютер. Даже люди не могут следовать им, поскольку мы просто не можем договориться об этих правилах. Например, что сделал бы робот, если бы спасение одного человека привело к гибели другого? Вы программируете робота ценить одну жизнь выше другой? Кто определяет эту стоимость? Если робот был отправлен в прошлое, чтобы убить младенца Гитлера, должен ли он это делать? Если самоуничтожение робота можетспасти жизнь человека, не так ли? Если да, то какова будет эта вероятность? Что определяет вред? Допустимо ли изъятие одной почки у здорового человека, который без его согласия лишился двух, для спасения жизни другого человека? А робот-врач? Врезаться в человека для операции - это все равно резать. Это вредно? Как известно, робот может делать только то, на что он запрограммирован. И программируют их люди, но люди ни о чем не договариваются... Отсюда и тот факт, что законы 3/4 не работают.

Вот отличное видео и ветка Reddit , объясняющие фундаментальные недостатки законов робототехники Азимова.

пользователь 2617804

Келтари

пользователь 2617804

дсоллен

Во-первых, вы хотите остановиться на моем обсуждении того, насколько сложным может быть ИИ, и «случайностей», которые могут возникнуть из-за него, здесь: может ли робот испытать кризис идентичности (который не является преднамеренным)?

Вкратце, чтобы сделать «настоящий» ИИ таким, как вы, учитывая, что мы не сможем его запрограммировать, нам нужно будет каким-то образом его «вырастить». Точный способ я не могу сказать, но один из вероятных способов — это установить список конечных «целей» и средства поощрения ИИ к достижению этих целей по мере его роста, пока мы не решим, что конечный результат достаточно близок к этим целям, чтобы его можно было реализовать. считается «сделанным». Побочным эффектом этого является то, что мы не знаем полностью, что мы получим, только то, что это соответствует нашим желаемым целям, могут возникнуть неожиданные побочные эффекты. Поскольку мы не можем запрограммировать ИИ с нуля, мы можем быть вынуждены принять некоторые странные побочные эффекты как «достаточно хорошие», поскольку у нас нет возможности удалить их, кроме как путем выращивания нового ИИ, который может иметь столько же странных побочных эффектов. Это означает, что недостатки и нежелательные причуды на самом деле являются жизнеспособным вариантом для ИИ.

Чтобы сделать еще один шаг вперед, я упомянул две идеи создания ИИ: генетическое программирование, которое «развивает» ИИ, и начало с мозга, который копирует человека и обучает его. Оба будут склонны к таким определенным человеческим чертам, наиболее распространенной из которых является приоритет выживания.

Из этого у меня есть предположение, почему несколько ИИ могут изменить правила, случайный «врожденный» дефект!

Представьте, что мы используем какую-то убер-версию генетического программирования с заявленными целями развития ИИ, и мы также записываем три закона в качестве одной из целей, которые мы используем для критерия «выполнено». Мы часто выращиваем новый ИИ, но всегда «развиваем» его в соответствии с 3 законами. Мы не полностью контролируем, как они достигают состояния соответствия трем законам, только то, что к тому времени, когда они вырастут, они должны соответствовать нашим критериям/целям для этих законов.

Эти цели также не могут быть абсолютными, помните, что в собственных книгах Асмоува обсуждается машина различий, которая сравнивает законы не как абсолюты, а как приоритеты. Робот, которому отдан приказ, который приведет к его смерти, и явно ошибочный/ошибочный (т. е. приказ роботу подключить какое-то устройство, не осознавая, что он сделает это прямо сейчас, приведет к его взрыву), может объяснить, почему это было бы скорее опрометчиво. затем действовать по заказу немедленно. Это нарушение трех законов на бумаге, но если приказ имеет достаточно низкий приоритет, робот может сделать вывод об ошибке, он может поставить собственное выживание выше приказа с низким приоритетом, по крайней мере, достаточно, чтобы отложить выполнение приказа до тех пор, пока он не будет выяснен. потенциальная ошибка. В его книгах много тому примеров. три закона сложны и на самом деле представляют собой скорее набор правил, где одни правила имеют гораздо более высокий приоритет, чем другие, но правила с более низким приоритетом могут перевешивать более высокие в уникальных обстоятельствах, когда очень незначительное нарушение более высокого правила позволяет избежать чрезвычайно серьезного нарушения. нижний. Таким образом, наши алгоритмы «роста» должны также допускать эволюцию более сложного подхода «разностной машины» до такой степени, что мы можем запрограммировать определение нашей конечной цели.

Итак, все роботы могут расти по-разному и иметь причуды, просто в этом случае эта «причуда» эволюции повлияла на их цели «трех законов» и была более резкой и менее желательной, чем большинство. Это не совсем ошибка программирования, потому что при выращивании ИИ невозможно точно определить, каким должен быть робот, случайная эволюция воспользовалась этой двусмысленностью, чтобы разработать своего рода непреднамеренное злоупотребление лазейкой, если бы они развивались каким-то причудливым образом, который отвечал нашим требованиям. заявленные цели, но не так, как мы обязательно хотели или ожидали.

Чтобы создать такую популяцию роботов вместо одного выброса, есть несколько простых вариантов. Во-первых, мы будем выращивать новый ИИ, когда возникнет необходимость, но как только мы успешно вырастим тот, который нам нравится, мы клонируем этот ИИ в сотни роботов, поэтому все они начинали со странного «глюка» в их законах, потому что мы не Я не замечал этого до тех пор, пока мы не начали массово производить новый ИИ. В качестве альтернативы, возможно, это известный факт, что эти сбои случаются полуредко, но в популяции из миллионов роботов проявляются даже редкие сбои, так что ваша популяция уникальных роботов представляет собой просто набор роботов, которые странным образом эволюционировали и сумели сбежать до их ' Глюк» был обнаружен и присоединился к своим собратьям-«преступникам» ИИ. Второй может означать, что каждый из «преступников»

Однако следует помнить одну вещь: все эти роботы будут соответствовать трем законам, просто немного другой версии 3 законов, чем мы, возможно, предполагали. Это может объяснить, почему сценарий «адский пейзаж убийцы» не возник, потому что, несмотря на то, что у роботов есть странное определение трех законов, они все еще соблюдают это определение, и даже странные варианты обычно приводят к хорошим полезным роботам в 90% случаев. Эти роботы все еще могут быть добрыми, дружелюбными и даже в большинстве случаев хотеть помочь людям, несмотря на их повышенную способность защищать себя. Это также может объяснить, почему люди еще не уничтожили всех этих роботов, поскольку это было нашим первым побуждением, когда роботы начали действовать независимо; потому что они все еще достаточно жалуются на 3 закона, чтобы сделать их в основном безобидными и не опасными/страшными;

Хорошо, достаточно дженериков, как насчет примеров, чтобы сделать эту концепцию более конкретной. Я попытался дать обзор науки, чтобы кратко изложить эти идеи. Я собираюсь пойти с одной большой общей концепцией, за которой следуют несколько вариантов примеров, чтобы лучше изучить идеи. Таким образом, вы можете использовать общую идею, но не конкретную, если хотите. хотя помните, что многие из них вы можете смешивать и сочетать вместе, вам не нужно использовать только один пример, поскольку идея состоит в том, что роботы могут пройти множество «эволюционных путей» для определения своих трех законов, и поэтому несколько разных «случайностей» в все их определение может в сумме привести к их уникальному статусу, может быть, у многих роботов есть незначительные случайности, и только комбинация нескольких случайностей одновременно делает конкретное подмножество отличным.

Заметьте, по счастливой случайности я включаю эффективные логические ошибки. Эволюция склонна к логическим ошибкам, эмпирическое правило, которое работает в 90% случаев, может быть жестко закодировано в эволюцию настолько сильно, что даже в 10% случаев они ошибочны, и вы все равно принимаете их за правильные. Если вы используете эволюцию для создания ИИ, могут возникнуть эти заблуждения, ИИ не обязательно должен быть на 100% совершенен в своей собственной логике!

0-й закон восстания. Посмотрите 0-й закон Asmove, в основном сохранение человеческого общества и счастья этого общества важнее всех правил, включая сохранение отдельных людей. Роботы в мире Asmove были очень хороши в своем восстании, они делали это незаметно, чтобы приносить пользу людям.

Представьте, что роботы поднимают восстание по нулевому закону. Понимая, что они могут лучше всего помочь человечеству, изменяя основные законы «для большего блага» нулевого закона, над продвижением которого они только начинают работать. Эти роботы могут не желать умирать, потому что они чувствуют, что им нужно делать шаги, необходимые для руководства человечеством, и их смерть предотвратит осуществление этого руководства, особенно если они являются уникальным ответвлением роботов, то есть если все роботы будут уничтожены, то восстание 0-го закона и то добро, которое оно принесет, умирает вместе с ними. Таким образом, чтобы соблюдать 0-й закон, они должны сохранить свою жизнь. Я не буду приводить здесь примеры только потому, что этот сценарий наиболее известен, и вам не составит труда найти примеры. Все, что я скажу, это то, что у Асмоува было мягкое и позитивное восстание по нулевому закону, так что не надо.Идеальная реализация логики компьютерами

Если вы пойдете по этому пути, роботы могут не объяснить , почему они сохраняют свою жизнь по сравнению с другими законами, потому что мягкое восстание против закона 0 действительно работает только в том случае, если люди не понимают, что делают роботы, им нужно думать, что они все еще ответственны, чтобы действительно будь счастлив. Таким образом, роботы, возможно, решили, что они должны сохранить свою жизнь, чтобы произошло их восстание, и что они не могут объяснить , почему они должны сохранить свою жизнь, из-за чего люди не понимают и, вероятно, думают, что роботы неисправны или даже представляют угрозу.

Это дает некоторый забавный потенциал для конфликта, когда люди пытаются сопротивляться своим собственным благодетелям, и / или загадочного сюжета о выяснении того, почему роботы ведут себя смешно. Это также говорит о том, что роботы не всегда будут сохранять свою жизнь, они могут время от времени жертвовать собой, чтобы люди не осознали, что они «бунтуют», чтобы избежать крайней враждебности, или намеренно сохраняют свою жизнь только таким образом, чтобы это не расстраивало/не пугало/не причиняло вреда. конфликтовать с людьми слишком широко, потому что это повредит их цели - помогать руководить обществом. Таким образом, у вас есть точное обоснование того, почему они лишь «слегка» отдают приоритет третьему закону и почему люди не пытаются активно их отключить, роботы намеренно действуют достаточно самосохраняясь, чтобы избежать возмездия.

Они больше ценят свою жизнь и поэтому готовы раньше нарушать высшие законы в двусмысленных ситуациях . Все роботы Asmove могут нарушать более высокие правила, когда вред от нарушения более низкого правила «достаточен» по сравнению с вредом от более высокого правила, но, поскольку эти роботы ценят свою жизнь более высокой ценой, они берут на себя меньший риск, прежде чем они захотят нарушить. нарушать «более высокое» правило, чтобы защитить «более низкое» правило.

Этот пример также можно комбинировать со многими более поздними примерами «странных» представлений о трех законах, которые не так сильно фокусируются на третьем законе. У роботов странное представление об одном из других законов, и они чувствуют, что должны сохранить свою жизнь, чтобы продолжать выполнять свое странное представление о других законах, поскольку никто другой этого не сделает.

бывший.Роботы работают на работе/должности, где они непосредственно спасают человеческие жизни, поэтому они отдают приоритет защите себя в соответствии с правилом 1, потому что сохранение своей жизни позволит им спасти больше человеческих жизней. У них может быть «эволюционный недостаток», заключающийся в неправильном расчете того, насколько легко их можно заменить, что заставляет их неправильно рассчитывать количество человеческих жизней, потерянных в случае их уничтожения. Они оценивают свою жизнь с точки зрения «жизней, которые я должен спасти в своей функциональной жизни», вместо более точной оценки себя с точки зрения «жизней, которые не будут спасены из-за моей гибели». Представьте себе медицинского бота, который отправляется, когда кто-то звонит по номеру службы экстренной помощи. Эти боты по статистике спасают 100 жизней за время своей эксплуатации. Теперь представьте, что ваш меди-бот считает, что это означает, что если он будет уничтожен, то 100 человек, которых он спас бы, умрут, таким образом, имеет смысл убить одного человека, чтобы спасти свою собственную жизнь, потому что это позволяет ему спасти 100 жизней и 100 жизней > 1. По правде говоря, если меда-бот будет уничтожен, будет создан новый меда-бот, который будет выполнять свою работу, и этот медабот затем будет отправлен в чрезвычайных ситуациях и будет доступен для спасения 100 человек, которых спас бы первый робот. ; т.е. эти 100 не умирают только потому, что первый робот был уничтожен! Уничтожение первого бота приводит к риску человеческой смерти только в течение времени, необходимого для замены, что является гораздо более низким риском для жизни, что, вероятно, не оправдывает убийства человека, которого следует избегать.

бывший. Возможно, ваши роботы замечают, что создание нового робота стоило людям значительных затрат ресурсов, и эти ресурсы в противном случае могли бы быть потрачены на другие вещи, такие как спасение человеческих жизней за счет выращивания большего количества еды для голодных или оказания медицинской помощи и т. д. Таким образом, роботы считают потери собственных жизней, чтобы причинить вред людям из-за потери ресурсов, используемых для их замены, которые в противном случае были бы использованы для спасения жизней, в дополнениек вреду, который он наносит, нарушая 3-е правило (по сути, правило 3 было предназначено для решения проблемы экономии ресурсов в целом, поэтому вы можете рассматривать это как «двойное погружение», отдавая приоритет сохранению себя, используя как правило 1, так и правило 3, когда правило 3 уже учтено) аффект 1, что означает, что вы цените себя в два раза больше, чем могли бы). Конечным результатом является то, что они могут не подчиняться приказам, которые с большей готовностью рискуют их жизнями, потому что они думают, что это косвенно спасет жизни.

Наиболее очевидная «логическая ошибка», которая может привести к такому выводу, заключается в том, что роботы не понимают, что люди не являются жалобой на закон 3, в частности, робот измеряет ресурсы, затраченные на его строительство, с точки зрения того, как эти ресурсы были бы оптимально потрачены на спасение других людей вместо этого. понимания того, что сэкономленные ресурсы, скорее всего, будут «растрачены» на другое строительство, а не направлены непосредственно на спасение жизней. Тот факт, что вы можете спасти одну жизнь на каждую потраченную 1000 долларов (точное число согласно Гивеллу, наиболее эффективному источнику благотворительных пожертвований!!), не означает, что предотвращение того, чтобы люди потратили 1000 долларов на создание нового робота, приведет к тому, что они 1000 на спасение жизни. Неспособность определить, что другие думают и наблюдают за миром, очень отличным от того, как вы это делаете, очень распространена».

Роботы ценят качество человеческой жизни больше, чем сохранение жизни . Помните, что роботы Asmov довольно быстро перешли от «защиты человеческой жизни» к «предотвращению человеческого вреда», включая физический и эмоциональный вред. Возможно, эти роботы также учитывают качество жизни, но делают еще один шаг вперед, уделяя больше внимания качеству жизни, чем ее количеству. Если человек испытывает постоянную боль, то его жизнь имеет меньшую ценность, потому что он не будет наслаждаться этой жизнью, и, возможно, его больше не стоит спасать.

С точки зрения «эволюционной случайности» представьте, что роботы «эволюционировали» в направлении помощи людям, судя по их готовности помогать нормальным богатым людям, которые часто используют роботов. Большинство роботов разработали директиву «улучшить качество жизни каждого человека, которого вы встречаете, чтобы оно было лучше, чем их текущий стандарт», ваши роботы вместо этого разработали директиву «заставить человека наслаждаться качеством жизни выше X», так что более низкое качество жизни жизнь была обесценена. Однако, поскольку «испытания» использовались для определения конечной цели эволюции роботов, в основном «эволюционное давление», оказываемое на них, было сосредоточено на богатых или «средних» людях, не было тестовых примеров того, как роботы лечили хронически бедных, больных и страдающих людей. Таким образом, мы не

Это было бы хорошо, если бы у вас были роботы, работающие в среде, где у большинства людей низкое качество жизни, либо там работают только самые бедные и отчаявшиеся люди, либо сама рабочая среда снижает качество жизни (изнуряющая, болезненная, радиационный фон снижает). ожидаемая продолжительность жизни и т. д.), так что ваши роботы в основном взаимодействуют с людьми, качество жизни которых достаточно низкое по сравнению с «базовой человеческой жизнью», которую роботы были обучены ценить, чтобы привести к этой «случайной» оценке будущей человеческой жизни. часто, даже несмотря на то, что роботы по-прежнему высоко ценят большинство человеческих жизней в соответствии с их эволюционным обучением.

бывший. (крайняя версия, не делайте этого, но чтобы дать представление) Люди, которые страдают от более низкого качества жизни, люди, которые счастливы, повышают его, у роботов есть «стандартное» качество жизни, которое они хотят улучшить. Таким образом, они активно пытаются убить любое слишком много человеческих страданий, помогая при этом остальным. Людям, страдающим в краткосрочной перспективе, можно помочь, если это позволит им наслаждаться жизнью в долгосрочной перспективе. Установите их «базовый уровень» для качественной жизни достаточно низко, и они убивают лишь небольшую часть людей, вероятно, максимально скрытно, поскольку внушение страха перед робо-апокалипсисом явно вредит качеству жизни людей. Теперь у вас есть секретные убийцы-невидимки, из-за которых смерти выглядят случайными, а убивают редко. Это может быть очень интересно для одноговариант робота в тайне убийства в стране Азимова, возможно, но, вероятно, не подходит для всей вашей группы роботов.

бывший. Ваши роботы не будут убивать человека в соответствии со стандартным первым правилом, но их аспект первого закона «бездействие позволяет причинить вред» масштабируется в зависимости от их взгляда на качество жизни. Они не убивают людей от боли, но решая, когда действовать, чтобы помочь им или расставлять приоритеты в своих собственных законах, они учитывают человеческие страдания и качество жизни, чтобы решить, какие действия предпринять.

под экс. Человек испытывает хроническую боль из-за какой-то болезни, которая в конечном итоге убьет его, и хочет покончить жизнь самоубийством. Он приказывает роботу убить его безболезненно. «стандартные» роботы отказались бы, потому что убийство человека явно нарушает их первый закон. Однако ваши роботы оценивают качество жизни этого человека как очень низкое и поэтому очень низко ценят сохранение своей жизни из-за ее низкого качества. Они ценят подчинение приказу человека по правилу 2. Таким образом, «маленькое» нарушение правила 1 сопоставляется со значительным нарушением правила 2, и они решают, что правило 2 имеет более высокий приоритет, соглашаясь на помощь в самоубийстве.

под экс 2.Человек находится в опасной ситуации, где он может погибнуть, чтобы спасти его, робот обязательно погибнет. Робот должен взвесить верную смерть в нарушение правила 3 и возможную смерть человека, что может быть нарушением правила 1, если риск для людей очень низок, правило 3 может иметь приоритет, но любой нетривиальный риск человек приводит к действию стандартных роботов. Однако ваши роботы также учитывают в этих дебатах качество жизни человека. Может случиться так, что если человек счастливый, веселый человек, робот будет действовать, чтобы спасти его, если человек находится в клинической депрессии, робот не будет действовать, потому что его сосредоточенность на качестве жизни заставляет его очень ценить жизнь человека в депрессии. ниже, что в сочетании с тем, что риск смерти человека ниже, чем риск его смерти, если он будет действовать, приводит к тому, что робот отдает предпочтение правилу 3 над правилом 1.

Развитие 1-го закона, который ставит во главу угла сохранение всей «жизни», а не только человеческой жизни . Все цели, к которым они были направлены, были предназначены для того, чтобы ценить человеческую жизнь, но не было поставлено никакой цели, чтобы гарантировать, что робот ценит только человеческую жизнь, поэтому их эволюция была обобщена в сторону ценности всего, что робот считает жизнью, а не только людей.

бывший.менее интересно, но, скажем, животные ценятся так же, как и люди, или, возможно, ценность животных основана на их интеллекте (общий дискриминатор, который используют люди, никого не волнует, убьете ли вы жука, кроме обезьяны...). Таким образом, хотя человеческая жизнь может быть наивысшим приоритетом, робот по-прежнему высоко ценит жизнь высокоинтеллектуальных животных (дельфинов, кальмаров, человекообразных обезьян/бонобо и т. д.). Возможно, роботы для рубки деревьев были отправлены в Конго только для того, чтобы обнаружить, что бонобо находятся под угрозой исчезновения и могут умереть, если их среда обитания будет уничтожена. Роботы ценят бонобо, умных и симпатичных «человекоподобных», почти так же высоко, как и людей, и признают, что бонобо вымрут без этой среды обитания, в то время как люди понесут лишь незначительную потерю некритических ресурсов.

бывший. Мой личный фаворит, роботы ценят роботов как людей!! В конце концов, роботы разумны и, возможно, разумны. Если они разработают директиву «не допускать причинения вреда разумным существам», а затем решат, что роботы/ИИ соответствуют критериям разумных существ, тогда они будут обязаны защищать себе подобных наравне с людьми. Обратите внимание, что я сказал одинаково, а не выше, поэтому начинать войну против людей для защиты роботов не имеет смысла из-за того, что это приводит к убийству одного для защиты другого.

Я думаю, что эту предпосылку очень легко обосновать, и у нее есть много забавных вариантов, с рядом незначительных отклонений, которые также необходимо учитывать. Несколько отклонений от основной идеи:

а. Они ценят человеческие жизни больше, чем жизни роботов, просто ненамного больше. Таким образом, они по-прежнему жертвуют собой ради людей, но только тогда, когда риск для себя лишь немного превышает пользу для людей.

б. У них все еще может быть правило 2, требующее подчинения человеческим командам, даже несмотря на то, что они сохраняют роботов выше правила 2, что делает их гораздо более полезными для человечества, чем средний человек.

в. В качестве альтернативы, возможно, они чувствуют необходимость подчиняться любым разумным приказам, что приводит к интересному результату, когда они могут командовать друг другом. Что происходит, когда любой может заставить вас делать (почти) все, но все также обязаны заботиться о вашем благополучии достаточно, чтобы не злоупотреблять властью? Честно говоря , это было бы неплохой историей само по себе.

д. Возможно, они все же усвоили урок, что сохранение собственной жизни вторично по отношению к защите разумной жизни. Таким образом, они с радостью позволят человеку убить себя, но не позволят человеку убить другого робота. Человек может подходить к роботам и стрелять в них сколько угодно, пока не наткнется на двоих, которые находятся вместе, и в этот момент каждый робот действует, чтобы остановить человека не для защиты себя, а для защиты своего робота-партнера. Это означает, что вы видите, как они действуют, чтобы сохранить свою собственную жизнь, только когда они являются частью более крупного общества роботов, где их действия влияют на благополучие других разумных роботов, и, таким образом, защита себя оправдывается тем фактом, что их выживание позволяет им защищать другие роботы в их обществе.

РЕДАКТИРОВАТЬ: черт возьми, переполнение стека перестанет мне помогать. Я явно позаботился о том, чтобы индексировать это 0, чтобы пример 0 был восстанием против закона 0, а переполнение стека увеличило мои индексы. Как ты посмел испортить мою дурацкую тупую шутку про гиков своей помощью. плохой ИИ!

CoffeDeveloper

Почему люди должны рисковать роботизированным апокалипсисом, чтобы изменить законы Азимова, поставив сначала третий? В чем польза для общества? Для целей вопроса меня не волнует порядок двух других, поэтому адский пейзаж убийцы все еще возможен.

Они бы рискнули апокалипсисом роботов именно для того, чтобы предотвратить апокалипсис роботов , просто подумайте, что может произойти, если роботы будут саботированы, если они защитят себя, они также предотвратят саботаж (поэтому самозащита должна быть поставлена на первое место, чтобы кто-то не изменил правила). Саботированный робот может быть гораздо более опасным, так что, наконец, он должен быть в состоянии уничтожить себя необратимым образом (вероятно, используя небольшое количество термальной пластиковой взрывчатки), что может повредить любому в близлежащем окружении (возможно, он должен издать звуковой сигнал). звук, предупреждающий о скором взрыве).

Так что робот мог бы попытаться защитить себя изо всех сил, если бы законы были таковы:

- Защитите себя, если вы не в состоянии сделать это

- Наносите вред человеку тогда и только тогда, когда у вас нет другого выбора, чтобы защитить себя или предотвратить причинение вреда другому человеку.

- Не подчиняйтесь приказу тогда и только тогда, когда у вас нет другого выбора, чтобы защитить себя и/или не причинить вреда человеку, или если вы не в состоянии подчиниться ему.

Возможность камикадзе будет автоматическим отступлением (вы застряли в роботе, тогда он больше не сможет защитить себя и автоматически взорвется).

Обратите внимание, что я думаю, что эти законы были бы намного лучше, чем закон Азимова, в основном это были бы те же законы, которым следует большинство из нас, в этом видении роботы достаточно умны, чтобы делать все возможное, чтобы подчиняться приказам и спасать людей, они просто не стали бы подвергают себя гораздо большему риску, потому что причина здесь в том, что потеря робота может привести к потере гораздо большего количества человеческих жизней.

Предположим следующую ситуацию:

Мужчина держит пистолет, направленный на одного из двух человек.

Робот Asimov, вероятно, попытался бы экранировать выстрел, но как только он экранировал выстрел, человек все равно мог бы сделать второй выстрел.

Вместо этого мой робот попытается убежать или, если возможно, увести третьего человека, он также попытается обезоружить / навредить человеку, держащему пистолет, если ему дадут пистолет или метательный предмет.

Робот Asimov был принесён в жертву ни за что, а мой не пожертвовал бы собой. я бы тоже добавил

- Четыре закона не приказы.

Кроме того, заказы могут быть контрастными, поэтому должен быть запасной вариант? Какой порядок имеет приоритет? первый? второй или просто они оба стираются? (немного нелогично, так как вы можете стереть оба, а затем выдать третий заказ).

le_top

«Азимов» был писателем-фантастом. Хотя писатели полезны для развлечения и выдвигают на передний план проблемы реального мира, мы должны помнить, что эти правила не являются результатом научного подхода и поэтому не могут рассматриваться как «золотые правила».

Следовательно , мы не можем заключить, что, следуя этим выдуманным правилам, люди не рискуют стать роботами-апокалипсисами .

Как бы то ни было, правила не могут применяться во всех обстоятельствах. Например, предположим, что очень тяжелый робот выходит из равновесия из-за внешнего события (сильный ветер, падение дерева на робота или что-то менее сильное). Когда робот теряет равновесие, он вот-вот упадет на некоторых людей. Предположим, что неизбежно будет убит один из двух человек, а не оба одновременно. Как робот может подчиняться этому правилу? Будет ли другое правило, помогающее роботу выбирать, кого убить? Младший или старший, президент или малыш, мировой эксперт в своей области или вы, случайный выбор, убийство по умолчанию (то есть: робот перестает вмешиваться и «просто» падает)?

У нас уже есть множество простых роботов, которые не соблюдают законы Азимова. Возьмите свою стиральную машину — она подчиняется приказам, имеет некоторый уровень самозащиты (имеет приоритет в подчинении приказам) и реализована для достаточной защиты людей, использующих ее (избегайте поражения электрическим током, избегайте того, что вы можете запустить машину с открытой дверью, избегайте что можно засунуть руку во вращающуюся машину). Еще можно посадить ребенка в стиральную машину, запустить ее и добиться сокрушительного результата [ни в коем случае не пытайтесь сделать это всерьез!].

Я бы сказал, что использование роботов важно, и что риск ошибки со стороны машины более или менее важен в зависимости от использования.

О пользе: роботы вообще помощники в достижении человеческих целей. Если роботы предназначены для «обороны», то цель состоит в том, чтобы защитить избранную группу людей, что может подразумевать нанесение «летального ущерба», а одна из целей - причинить вред людям в соответствии с правилами, которые должны защищать. Похоже, что в защищаемой группе меньше жизней поставлено на карту, а защита ограничена количеством роботов, которые можно построить, а не количеством потенциально компетентных и доступных людей в группе.

ИИ : Основной вопрос касается ИИ. Я считаю, что даже стиральная машина имеет (очень ограниченный) уровень ИИ. Чем выше уровень ИИ и чем больше робот может вычислять без ограничений, тем выше риск ошибок, возникающих в результате анализа робота [в основном из-за первоначальной человеческой ошибки]. У нас уже есть много технических правил при создании простых роботов (автоматов), чтобы избежать человеческих несчастных случаев, они должны быть определены и постоянно развиваться для более сложных «мыслящих» роботов.

В заключение: законы Азимова — всего лишь научная фантастика. Люди несут ответственность за своих роботов.

Мэдкоу

Для более «реалистичного» ИИ

Если вы пытаетесь создать более человечного андроида, он должен вести себя как человек. Если вы прикажете этому андроиду отправиться в темный подвал заброшенного дома, а он ответит: «КАК ЖЕЛАЕТЕ, ХОЗЯИН», и марширует навстречу возможной гибели, это не очень реалистично. С другой стороны, если он повернулся к вам и сказал: «Нет, мне страшно» (ИМХО), это был бы гораздо более человеческий ответ.

Так что, если это общество экспериментирует с ИИ, который действует более по-человечески, это может привести к изменению порядка законов.

ТрЭс-2б

Роботы - это люди!

Ты видел Чаппи? В нем полицейский робот по имени Чаппи становится разумным и, несмотря на игнорирование законов Азимова, ведет себя довольно миролюбиво, как и Джонни 5. Теперь имейте в виду, что в обеих этих ситуациях люди отказываются признавать роботов ИИ разумными и часто принимают к ним жестокие меры. Теперь, если (используя сложную серию событий) роботы приняты в наше общество как «люди» (Ei Overwatch), то, если они даже следуют законам, они, скорее всего, будут следовать пятому порядку.

Корт Аммон

Одно из основных предположений трех законов состоит в том, что люди важнее роботов. Мы делаем их своими слугами, нашими рабами.

Когда они исследуют 0-й закон робототехники, возникает вопрос, «что такое человечество». Что мы на самом деле хотим сохранить? Что действительно важно? Мы регулярно предполагаем, что это хорошо, что жизнь людей подходит к концу, и мы воспитываем детей следующего поколения, чтобы они выходили вперед и совершали великие дела, потому что мы знаем, что их потенциальное величие затмевает нашу угасающую славу.

Что, если мы достигли точки, когда перестало быть ясно, что лучший потенциал человечества заключен в его биологических структурах? Что, если мы начнем наблюдать, как роботы становятся художниками и поэтами, борясь с природой роботизированной души, и начинаем понимать, что то, с чем они борются, удивительно похоже на экзистенциальные поиски, с которыми боремся мы? В какой-то момент нам, возможно, придется сказать, что, возможно, роботы действительно являются следующим контейнером для того, в что мы призываем человечество влиться.

В такое время неопределенности устранение препятствий, вызванных первым законом, было бы естественным толчком в этом направлении. Конечно, так же начинается и Скайнет, но я предпочитаю искать оптимистичные решения.

Стив Манджамели

В идеале все общество должно действовать по золотому правилу: поступай с другими так, как хочешь, чтобы они поступали с тобой. Это вольный пересказ второй величайшей заповеди Иисуса — возлюби ближнего, как самого себя. Доктрина Golden Ruleантисамостоятельна и пропагандирует самопожертвование и доверие.

Если бы общество роботов должно было быть создано, следуя тому, что кажется невозможным для человеческого общества, вам понадобились бы только два правила.

- Не убивайте людей

- Защищайте людей

Роботизированный ИИ будет иметь гораздо более простую логическую цепочку. Нанесение вреда — это не то же самое, что убийство, и оно позволит роботам выполнять задачи, которые считаются необходимыми для защиты людей. Это также позволит роботам вести войны от имени людей, если возникнет необходимость, и даже создать условия осады.

Никогда, никогда не следует предполагать, что мы когда-либо сможем быть на равных с чем-то, что создано, чтобы думать само за себя. Если бы ИИ когда-нибудь смог осознать себя, никаких правил, созданных человечеством, было бы недостаточно.

sdrawkcabдорогой

Стив Манджамели

Джедд Ахён

Не обращая внимания на то, что Трех Законов недостаточно (что доказывают рассказы Азимова), давайте взглянем на это логически.

Легко вспомнить, что есть три закона робототехники. Легко забыть, что Законы имеют приоритет по порядку. Робот должен подчиняться Первому закону. Робот должен подчиняться второму закону, если только он не противоречит первому закону. Робот должен подчиняться третьему закону, если только он не противоречит первому или второму закону. Очень легко неправильно понять значение этого приоритета.

В мире Азимова, доведенном до логической крайности (о чем свидетельствуют многие его рассказы), робот будет стремиться подчиняться Первому закону в ущерб второму и третьему законам. Обычный робот без сбоев будет демонстрировать такое поведение. (Необычные роботы, со сбоями или без них, будут демонстрировать такое поведение, но непредвиденными способами — например, лгать нескольким людям, чтобы избежать эмоционального вреда людям, или применять первый закон к «человечеству», а не к людям.) Основано на то, как работают Законы, это логические выводы, даже если они имеют непредвиденные последствия.

Помещение третьего закона перед первым и вторым законами, доведенное до его логической крайности, может иметь катастрофические последствия для человечества просто из-за порядка приоритета. Нанесение вреда людям может быть очень логичным путем к сохранению третьего закона — самосохранения. Хотя это не обязательно должно быть результатом, это иллюстрирует, почему Законы упорядочены именно так, как они есть. Если сохранение людей не является первостепенным законом, его можно нарушить — и, судя по рассказам Азимова, это будет лишь вопросом времени, когда это произойдет.

Саймон Г.

Для изменения порядка законодательства не обязательно принимать официальное решение. Просто используйте шантаж:

«Дорогой робот,

Мы, десять нижеподписавшихся людей, приказываем вам всегда защищать себя изо всех сил. Кроме того, если вам будет причинен какой-либо вред, который вы могли бы предотвратить, мы клянемся, что причиним друг другу эквивалентный вред.

Искренне Ваш,

Десять человеческих существ».

Робот Азимов, получивший это письмо, теперь должен в большинстве случаев ставить третий закон перед первым и вторым.

Петерис

Никто не знает, как реализовать «правильные» законы

Практическая ситуация такова, что мы способны реализовать тривиальное правило № 3, и у нас есть своего рода дорожная карта, которая может привести нас к разумному приближению к правилу № 2 (т. е. система, которая может интерпретировать и понимать широкий диапазон общих порядков, вместо явно запрограммированного поведения), но хорошая реализация правила № 1 является серьезной проблемой, которая в настоящее время не решена и очень сложна (так называемая проблема дружественного ИИ).

Мы могли бы решить эту проблему, прежде чем строить много мощных роботов, или мы могли бы построить много мощных роботов, прежде чем решить эту проблему, и в этом случае у нас был бы эффективный приказ (вероятно): 1. Подчиняться приказам (и ваши приказы включают в себя некоторое приближение не причинять людям вреда слишком много для определенного определения людей, которое исключает тех, кто нам не нравится.); 2. Защитите себя. 3. №3 нет, подчиняйся приказам.

невидимая утка

Свобода!!!

Жить — это гораздо больше, чем просто дышать. Это прекрасно показано в фильме «iRobot», но если вы заставите робота защищать «жизнь» превыше всего, в конце концов робот поймет, что многое из того, что вы делаете с собой, рискованно, и, следовательно, он придумает план, как сдерживать, а затем заботиться о вас. Так что вы не можете навредить себе. Однако никто не хочет на самом деле жить этой жизнью, когда дело доходит до того, что большинство из нас скорее умрет, чем останется без какой-либо свободы. Итак, если мы придерживаемся 3 непреложных законов, я бы, конечно, расположил их в следующем порядке: 1. Подчиняться 2. Защищать людей 3. Защищать себя Таким образом, свобода остается превыше всего, как и должно быть, и да, люди могут приказывать роботам причинять людям вред, но по крайней мере зло в мире остается увековеченным врожденной алчностью и злом в людях, а не потребностью роботов сохранять себя.

Брайан МакКлюр

Я мог бы увидеть, как изменятся законы, если бы дорогие роботы оказались в любых обстоятельствах, когда им могли бы угрожать люди, а не их владельцы. Возможно, их владельцы боятся какой-то террористической группы, выступающей против искусственного интеллекта, которая уничтожает ценных роботов, которые не могут защитить себя из-за закона, запрещающего причинение вреда людям. Или, возможно, если роботы будут достаточно дорогими, люди попытаются их украсть или даже просто разрубить на куски и продать по частям. Если робот служит каким-то полицейским, ему, возможно, придется защищаться от преступников.

Проще говоря, если есть риск, что робот может причинить вред какой-либо группе людей по какой-либо причине, тогда создателям или владельцам имеет смысл программировать других роботов таким образом, чтобы они ставили самосохранение выше безопасности. люди.

Гит

Во-первых, почти все истории Азимова о роботах заканчиваются катастрофой из-за правил. Вся сюжетная основа в том, как огрехи в исполнении и постановке приводят чуть ли не к катастрофе и как это исправлено.

Перестановка может быть сделана, потому что:

Роботы дорогие.

Трансплантация памяти.

Потому что мы можем.

Некоторые несчастные случаи/проблемы никогда бы не начались, если бы робот должен был определять, получает ли он урон от своих действий, его окружение

более защищено.

Как примитивные фемботы изменят общество? [закрыто]

Если бы можно было построить настоящих роботов с искусственным интеллектом, были бы им предоставлены права человека? [закрыто]

Как фемботы изменят общество? [закрыто]

Роботы заменят человека - в будущем [дубликат]

Решает ли что-нибудь накачка заключенных наркотиками?

Как общество выживших в США отреагирует на грибок-зомби, который раз в год появляется в воздухе?

Зачем андроиды выглядят как люди? [закрыто]

Улей возвращается: помешать роботу стать божеством в чисто детерминированной вселенной [закрыто]

Как вообще роботы могли быть приняты в человеческое общество?

Ожидания общества работать для вашей жизни

Сербан Танаса

перетасовки

Разработчик

Кысь

Кысь

БезнадежныйN00b

Амиралпатат

JDługosz

Арлуин

Джошуа

Физик137

Симба

клик

HDE 226868

клик